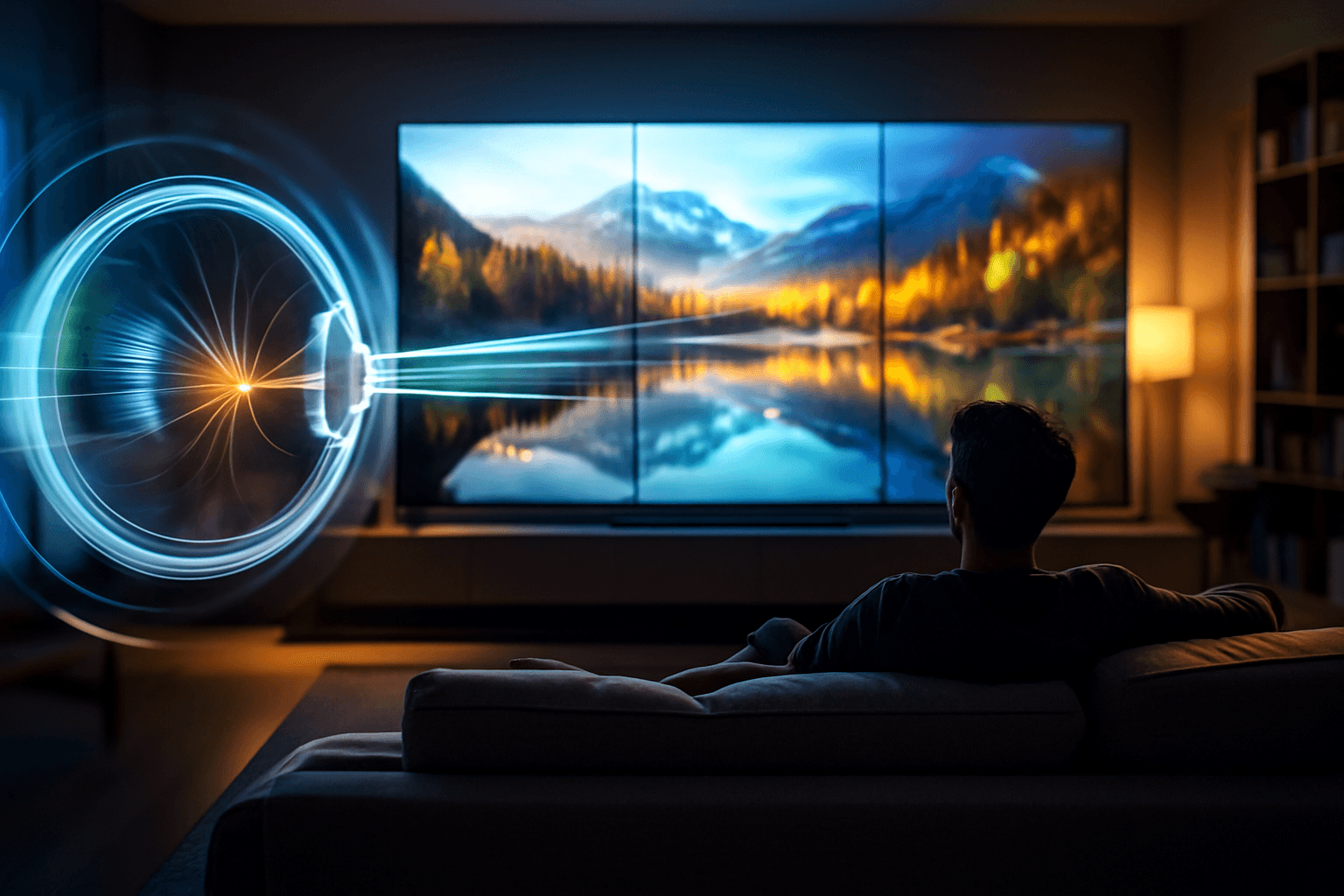

Najnowsze badania Uniwersytetu Cambridge we współpracy z Meta Reality Labs podważają to, co przez lata uznawano za „twardą” granicę ludzkiego wzroku. W skrócie: nasza siatkówka może rozróżniać więcej szczegółów, niż sugerowały wcześniejsze normy, ale paradoks polega na tym, że w typowych warunkach domowych i tak nie wykorzystujemy pełnego potencjału ultrawysokich rozdzielczości oferowanych przez współczesne telewizory.

Czy oko naprawdę „widzi” 4K i 8K? Nie tak, jak myślisz

Badania wykonano w realistycznym, domowym scenariuszu – typowy salon, widz na kanapie, telewizor o przekątnej 44 cale. Wynik? Przy standardowej odległości wzrokowej większość osób nie jest w stanie dostrzec pełnych detali ekranu 4K, a tym bardziej 8K. W konsekwencji, z takiej odległości telewizory 2K potrafią wyglądać niemal identycznie, jeśli liczy się wyłącznie percepcja ostrości.

Nie oznacza to jednak, że nasze oczy są słabe. Wręcz przeciwnie – ich granice są wyższe, niż sądzono, ale dopiero precyzyjne, laboratoryjne testy pozwalają to jednoznacznie wychwycić.

Nowe dane: rozdzielczość naszego wzroku zależy od koloru

Aby dokładnie zmierzyć percepcję detali, naukowcy nie posługiwali się już tradycyjną tablicą Snellena. Zamiast tego zastosowali pomiar w pikselach na stopień pola widzenia (ppd), co jest znacznie bardziej adekwatne dla ekranów cyfrowych.

Wyniki prezentują się następująco:

| Kolor | Zdolność rozdzielcza (ppd) |

|---|---|

| Szarość | 94 ppd |

| Zielony | 89 ppd |

| Czerwony | 89 ppd |

| Żółty | 53 ppd |

| Fioletowy | 53 ppd |

Widać wyraźnie, że kolorowe treści są przez mózg i siatkówkę interpretowane inaczej niż te monochromatyczne. Nasz układ wzrokowy nie jest idealnym sensorem – to połączenie biologii, neurologii i ewolucyjnego kompromisu.

Dlaczego „więcej pikseli” to nie zawsze lepszy wybór

Branża RTV od lat stawia na wyścig rozdzielczości, ale wygląda na to, że doszliśmy do ściany. Dla przeciętnego użytkownika:

- większa rozdzielczość ≠ wyraźniejszy obraz

- odległość od ekranu ma większe znaczenie niż ilość pikseli

- percepcja kolorów ograniczana jest również przez mózg, nie tylko oko

- efekt 8K jest sensowny dopiero na bardzo dużych ekranach (tu mówimy raczej o rozmiarach w okolicach telebimów niż domowych TV)

Następny skok jakościowy powinien koncentrować się nie na pikselach, lecz na:

- kontraście i HDR

- odwzorowaniu kolorów

- dynamicznym dopasowaniu obrazu do percepcji widza

- optymalizacji pod kątem rzeczywistych warunków oglądania

Mózg – prawdziwy procesor obrazu

Ludzki mózg nie tylko odbiera sygnały wzrokowe, lecz również je „dopowiada”. To właśnie dlatego postrzeganie kolorów peryferyjnych wypada gorzej, a kontrast i porządek wizualny wpływają na odczuwalną ostrość bardziej niż surowa liczba pikseli. Innymi słowy: widzimy nie to, co jest, tylko to, co mózg uznaje za potrzebne.

Co z tym zrobią producenci?

Jeżeli firmy chcą tworzyć naprawdę „ludzkie” wyświetlacze, muszą odejść od marketingowej gry liczb na rzecz optymalizacji pod rzeczywiste możliwości i potrzeby użytkowników. Zamiast kolejnych 12K, lepszym kierunkiem wydaje się tworzenie ekranów inteligentnie dopasowanych do percepcji widza – tak, by 95% populacji widziało maksymalną możliwą jakość, a nie jedynie teoretyczną.

Podsumowanie

Nasz wzrok ma wyższą „rozdzielczość”, niż sądzono, ale równocześnie nie wykorzystujemy jej w typowych warunkach domowego oglądania filmów. Dzisiejszy wyścig pikseli zderzył się z realiami biologii: ludzie nie potrzebują coraz większej rozdzielczości, lecz mądrzej zaprojektowanych ekranów.

Wyniki badań opublikowano w czasopiśmie Nature Communications .